与往年一样,本届 CES 上,Mobileye 的 CEO Amnon Shashua 照例用了一个小时来阐述 Mobileye 的技术进展以及未来规划。而这一个小时反映出了 Mobileye 的宏大野心:从一个 Tier 2 ADAS 供应商逐渐转型为高级别自动驾驶出行服务商,构筑一个基于视觉技术的自动驾驶霸业。

野心背后的底气

在当今的 ADAS 领域,Mobileye 是毫无疑问的领头羊,其 EyeQ 芯片的市场占有率相较于其它供应商有着压倒性的优势。在产品上,EyeQ 芯片的优势体现在其优秀的视觉解析表现力,较高的系统稳定性,以及较低的功耗。并且不管是现在的 EyeQ4 还是未来的 EyeQ5, 其既可以用于中央域控制器,也可以直接整合在挡风玻璃上的前视摄像头模块当中,OEM 即使不想使用中央化的域控制器架构,也可以通过在分布式结构中整合 EyeQ 芯片,研发出一套成熟的 L2 甚至是 L2+ ADAS 产品。

随着自动驾驶行业遇冷,越来越多的汽车厂商开始意识到两个现实性问题:

- 出于场景和法律原因,L3 目前很难普及,未来的几年内,L2+才会是量产车 ADAS 领域内的主流

- 在短期内,应用高度中央化的域控制器平台需要从根本上改变现有的研发与供应链体系,且研发成本非常高。

既然花了大成本研发出的中央域控制器架构在短期内也就只能应用 L2+,那么为何不用成熟度更高的传统分散式架构做 ADAS,并保证利润呢?因此我们可以看到大部分车厂仍然仅会在高端车型中部署域控制器。正是这个原因,使得 Mobileye 的市场地位在短期内很难被撼动(目前市场上 70%的 L2+系统都采用了 Mobileye 的产品)。即使 OEM 和 Tier 1 都苦于 Mobileye 封闭的产品形态,也无法找到合适的替代供应商。

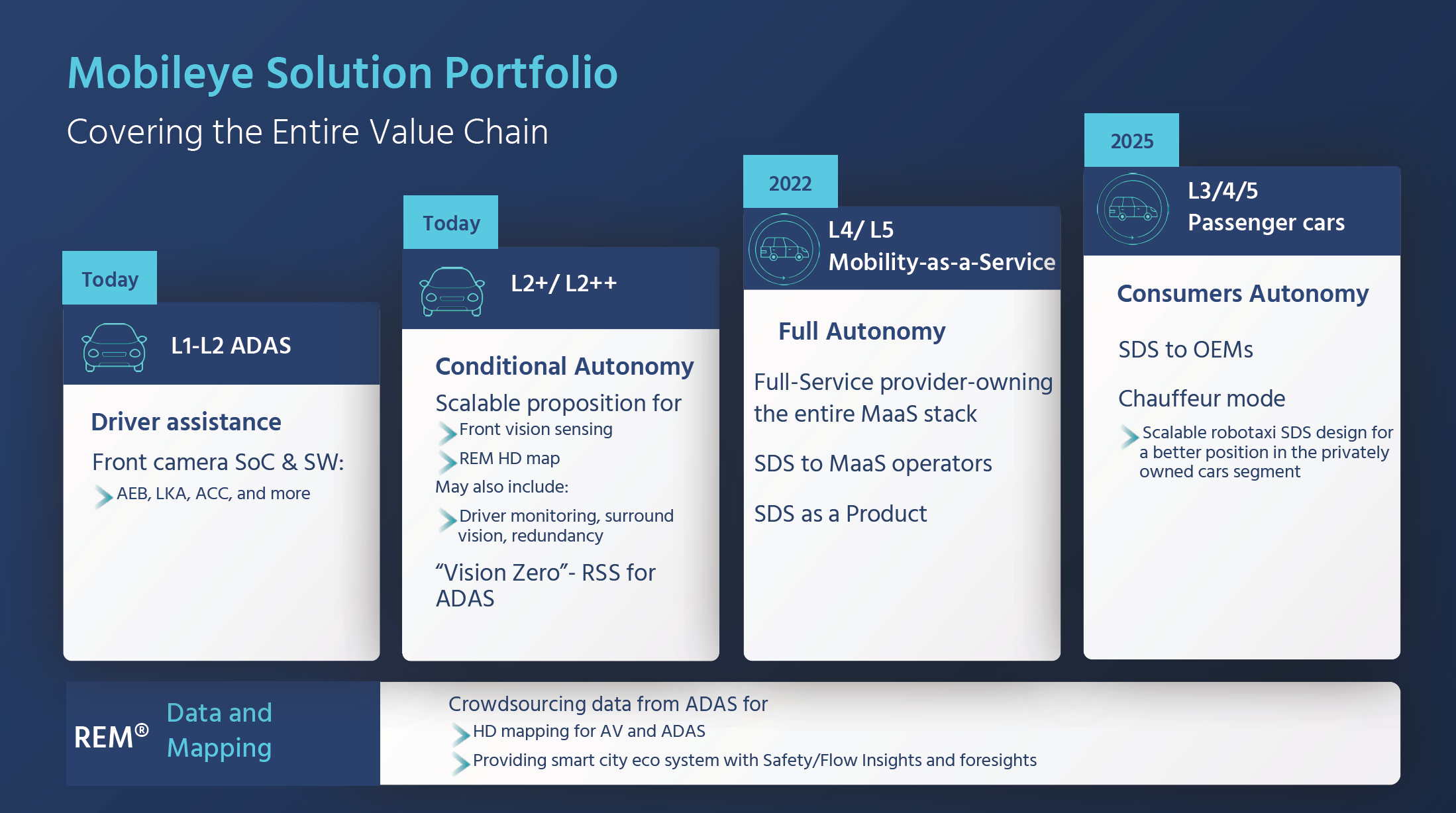

而靠着稳定前装市场份额所带来了的充沛造血能力(这里还没有算上 Intel 对他们的支持),Mobileye 可以底气十足的在尚不赚钱的高级别自动驾驶领域「烧钱」。按照 Shashua 教授公布的规划,Mobileye 将在 2022 年实现 L4 级别的出行服务部署(与大众和 Champion Motor 在以色列的合作项目,以及与蔚来合作的 L4 项目),在 2025 年推出面向量产车的 L3/L4/L5 全栈式自动驾驶系统(不只是提供芯片,而是提供完整的自动驾驶系统)。

以视觉为绝对核心的技术路线

除了特斯拉之外,Mobileye 也一直坚定的在走靠机器视觉实现自动驾驶的路线。在演讲的后半部分,Shashua 教授重点介绍了 Mobileye 的机器视觉路线。

首先,Mobileye 并没有完全放弃激光雷达 ,他们将激光雷达与毫米波雷达融合形成一套完整的环视感知体系,再用纯摄像头视觉形成一套完整的环视感知体系,两者互相独立,且各自都可驱动高级别自动驾驶的功能,前者的主要意义是作为后者的冗余层存在。换句话说,Mobileye 并没有做主流的多种传感器融合路线,而是将两种不同的传感器路线各做一套感知,再通过两套感知冗余叠加,实现更高的安全性。

更烧脑的是,Mobileye 在摄像头视觉这套环视感知体系当中,还同时使用了多种相互独立的感知算法实现冗余叠加,这么做的目的是为了在两个维度上进一步提升感知的精确度与稳定性,这两个维度分别是:

- Detection:决定感知的对象是什么物体

- Measurement:通过对摄像头的 2D 画面进行推理,得出感知对象的具体 3D 信息

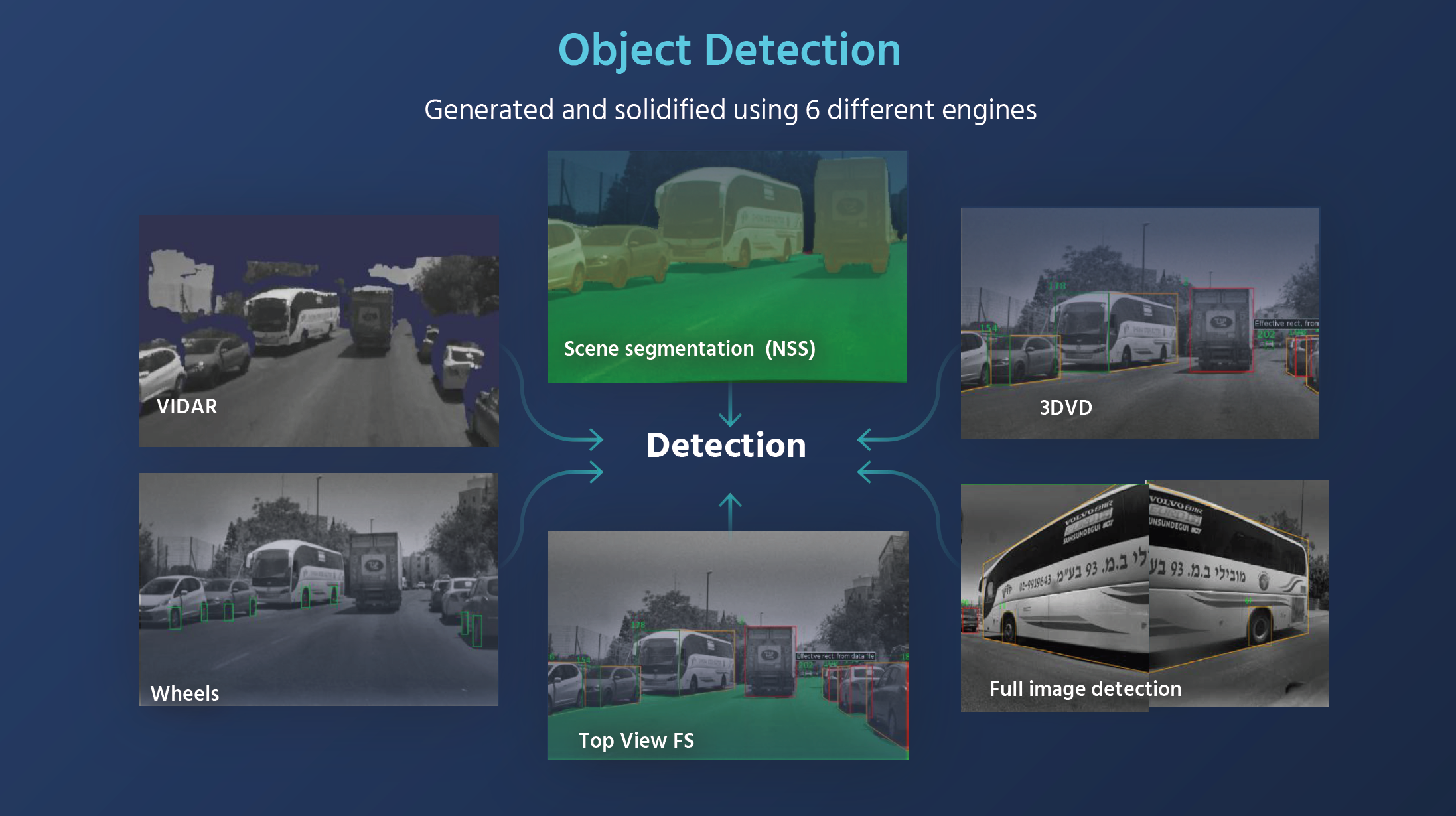

光是在 Detection 维度,Shashua 教授就在演讲时举例了 6 种他们所使用的独立算法:

- 3D Vehicle Detection(3DVD):识别 2D 画面中的目标车辆,将其标注上 3D 的 Bounding Box

- Full Image Detection:主要用于识别车辆两侧近距离的大型物体(如客车或卡车),由于单一摄像头的很难完整捕捉这类近距离物体,因此需要结合多摄像头捕捉的画面进行整体标注

- Top View Free Space:重点识别画面中没用被占用的道路并进行标注,通过排除法可以得出,没有被标注的空间都是有物体占用的

- Features Detection (例如 Wheels):重点识别物体独有的一些特质,例如车轮

- VIDAR:通过多个摄像头的交叉三角测量生成 3D 画面,再将这个 3D 画面导入到激光雷达的感知算法中进行物体识别

- Scen Segmentation(NSS):通过对摄像头画面进行像素级识别,分割出不同种类的物体并分别用不同颜色标注

可以看出,Mobileye 增加这么多种视觉算法的原因就是为了能够覆盖尽可能多的 Corner Cases,提高感知算法的鲁棒性。到这里,Shashua 教授的这堂课对于没有相关技术背景的人来说已经可以用「天书」来形容了。好在他的课件里还有大家都能看得懂的实车 Demo,截取自 Mobileye 在以色列耶路撒冷的一段开放道路测试,测试中的车辆在硬件方面仅仅使用了 12 路摄像头加一个 EyeQ5,而在软件上,除了用到了刚才提到的摄像头环视感知体系,还在驾驶决策上使用了 Mobileye 在 2018 年 CES 就发布过的 RSS 模型。(Demo 视频的俯视视角中,车顶印有 Mobileye Logo 的为测试车辆,其余均为公开道路上的社会车辆)

在 2 分钟的片段里,Mobileye 的测试车在没有人为接管的情况下完成了几个非常高难度的窄道会车,以及一个有大型公交车与行人干预的无保护左转弯,依靠纯视觉感知完成这样的高难度场景可以说是相当惊艳,这个 Demo 也赢得了现场的一片掌声。

这段 Demo 传递的信息很明确,Mobileye 正在全力扩展其视觉感知技术的场景覆盖范围,他们的目标是使用低价视觉系统(整套系统 1000 美元内)也能够完成高级别自动驾驶所需要的功能,并在安全性上超过人为驾驶。

霸业的雏形

其实 Mobileye 的总体策略非常的简单粗暴,主要包含 3 步:

- 在 ADAS 领域重点研发 L2+,继续巩固自身在这个市场当中的统治地位。本次 CES,Mobileye 公布了与上汽在 L2+领域的合作,上汽将采用 Mobileye 的 REM 技术,以推进 L2+级别 ADAS 系统在中国的部署

- 借助 ADAS 市场所赚取的利润与数据,不断发展打磨自身的视觉感知与驾驶决策技术,在提升自身 ADAS 表现能力的同时,努力覆盖更高级别的自动驾驶场景并提供更安全的表现。Shashua 教授演讲中的主要技术内容,正是围绕着这个环节展开的。

- 依靠自己强大的视觉感知技术体系在高级别自动驾驶领域与车厂及政府等展开合作,扩张自身的业务版图,最终完成从 Tier 2 到自动驾驶全栈供应商甚至是出行服务供应商的转型。在出行领域,Mobileye 此次公布了与韩国大邱广域市的合作,双方将共同测试和部署一项基于 Mobileye 技术的 Robotaxi 移动出行解决方案。

按照这个 3 步策略,Mobileye 并没有打算给自动驾驶价值链上的其他角色留下太多的「增值空间」,而是希望把链条内的关键性技术都牢牢地攥在自己手里,这会给 Mobileye 后续的发展带来最大化的主动权。

或许是出身以色列的缘故,Mobileye 有着一股业内独有的坚忍与强悍。目前冷静务实的市场环境给了他们充足的时间去布局自己的视觉自动驾驶霸业,而未来这个霸业的成败,不只取决于行业的变化,更取决于他们自身的表现。