话说,你用过手势交互吗?

这里指的不是你打个响指,背后就会冒出几十个壮汉一拥而上的那种手势。

我们所说的汽车上的手势交互,指的是车辆通过识别驾乘者的特定手势,来激活车辆的各种功能,甚至有可能进一步代替车内的各种物理或虚拟按键。

然而事实是,当下车内的隔空手势,成为我们目前看到争议最大的交互形式,没有之一。

支持者表示:「手势交互真是太酷了!代表了未来!」

反对者则有着各种各样的理由,他们觉得手势交互是噱头、不准确、不安全……千言万语汇成一句话:不靠谱儿。

按理说,手势是最符合人类直觉的交互方式之一,婴儿时期最先学会的感知方式就是抓和握。那为什么会产生这么大的分歧?车企们对待手势识别交互的态度,又为什么既渴望又谨慎?

所以,让我们一起看看,车上的手势交互,到底靠不靠谱儿。

手势交互,强在哪里?

当下,物理按键为王的时代还没有完全过去,但我们仍然看到了操控与交互变得越发多元化,语音、触控、手势、主动监测……万变不离其宗的是,感知与智能是实现这些交互方式的大前提。

就像移动电话经历了「大哥大——单色屏功能机——全键盘智能机——触摸屏智能机」这样的进化过程,随着硬件性能与网络连接能力的提高,更加多元化的交互方式也跟着水涨船高。

是的,自从连上网络,汽车也开始了属于它的快速进化时期。

也许有人会问,现有的交互形式不靠谱吗?为什么还在做加法?

走出座舱平铺开来看,在已有的交互模式中,各自了对应人类的五感:

触控→→触觉

语音→→听觉

手势→→视觉

这样来看的话,时下最火的智能语音也存在它的局限性。打个比方,当你处于奔跑、潜水、伞降等运动、「说」与「听」任何一边的生理通道被占满或不可用时,触觉与视觉的重要性就凸显出来。

麻省理工学院媒体实验室讲师、交互专家 David Rose 在他的文章《为什么手势会是下一个设计爆点》(Why Gesture is the Next Big Thing in Design)中提到,在分析研究结果后,将人们会选择手势而非语音或触摸,原因可以归结为四点:

速度 ——如果需要快速响应,手势比说话(语音)更快。

距离 ——如果需要跨越空间(距离)进行交流,做手势(视觉)比动动嘴巴更容易。

简洁 ——如果不是需要一次说很多事情,手势就比较好用。表达一定含义用到的手势越简洁,它就越容易被记住。例如,四指收拢、拇指向上来表示赞许、认可;反之则表示蔑视、轻视。

当强调表现力胜过准确性时 ——手势非常适合表达情感。乐团指挥者所传达的信息,除了重拍和节奏之外,还有更多的含义,如甜美(原文为意大利语「dolco」)、着重(原文为意大利语「marcato」)、自信、悲伤、渴望等等。

《星际迷航》(Star Trek)系列代表人物 Spock 的经典手势

《生活大爆炸》第四季中,Sheldon 摆出了 Spock 的经典手势,意为「生生不息,繁荣昌盛」

手势交互在车内的另外一个好处,就是使用者可以脱离实体输入设备的束缚,为用户提供更大范围、可以一定程度上模糊操作的交互方式。 作为最自然的沟通本能,车内手势能够极大地节约注意力和视觉通道的资源支出。

在完全自动驾驶实现之前,合理运用手势交互可以有效减少驾乘人员分心,更宝贵的是,能够与触控和语音等交互方式形成重要的互补体系。

让我们举个直观的例子。

GeekCar《智能座舱情报局》栏目在 2021 年 11 月评测过一辆全新奔驰 S 级轿车。这辆车搭载的 MBUX 智能感应助理可以捕捉驾驶员的手部动作,来进行辅助交互。支持的手势动作包括但不限于:

驾驶员将手放到后视镜下方,就可以开启和关闭前排阅读灯;

驾驶员将手在后视镜前方向前或向后挥手,就可以控制遮阳帘的开启与关闭;

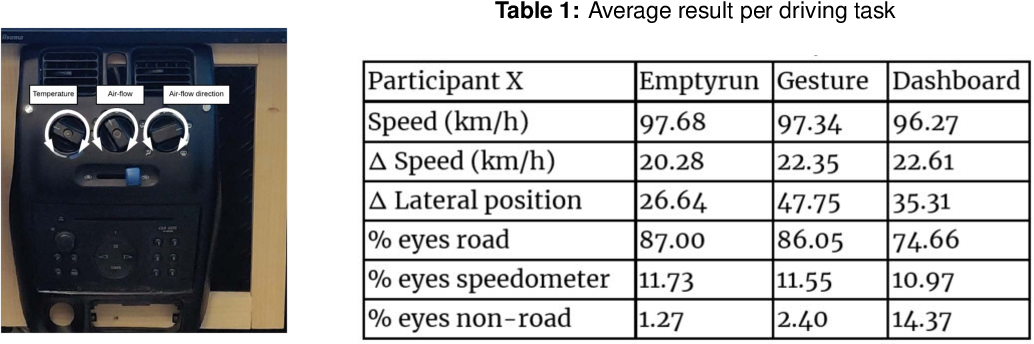

在 Automotive UI 2019 的论文《基于手势的界面对汽车应用安全性影像》(Effects of Gesture-based Interfaces on Safety in Automotive Applications)中,研究者以车内导航、温度、娱乐等非驾驶任务的手势交互为对象,将其对驾驶安全的影响进行了研究。

共计 25 人参加测试的实验中,研究者基于驾驶数据和眼动仪数据进行了综合分析。结果显示,使用手势的司机可能更有能力对突发状况进行响应。研究人员没有发现任何直接证据表明,仪表盘与手势交互之间,在速度、速度方差、车道位置变化等驾驶表现上存在过大差异。

需要强调的是, 交互方式有再多优势,也无法脱离使用场景。

我们无法保证车内一直是独属一个人的私密空间,也无法保证车内的氛围一直都适合用语音进行交互。让我们举个简单但实际的例子,当家中的小朋友好不容易哄睡、在婴儿床上摆个「大」字造型感睡得正香时,我宁愿用手机打开智能家居 App 来控制家电,也不要冒着再次吵醒人类幼崽的风险用跟智能音箱一来一回地互动、让电器们干活儿。

如大家所见,交互的进化是个特别有意思的过程,观察人们对交互手段的态度转变也是。

讲个小故事。大概十几年前,我在工作中偶遇一位美国的手机工程师老哥。恰逢我也要换新手机,于是就这个话题攀谈起来。还记得老哥对自家手机的全键盘赞赏有加,而对 iPhone 的触屏设计嗤之以鼻,数落出来手机没有实体按键之后的种种不适。

有意思的是,我们话别之后,工程师老哥走出一段距离,转头冲我喊道:如果你实在不知道选什么的话,iPhone 或许是个好的选择。

至于后来的事情就不用说了,今天的我们都是亲历者。产品的开发和大众的接受是个漫长的过程,交互方式的探索也如是。

事实是,手势交互正式进入车内,到现在还不到 10 年的时间。其间陆续有车企和供应商将隔空手势引入座舱,但总有批评的声音质疑其「华而不实」。然而车企和供应商们并没有放缓技术落地的脚步。

质疑声中 车内手势的发展没有停下

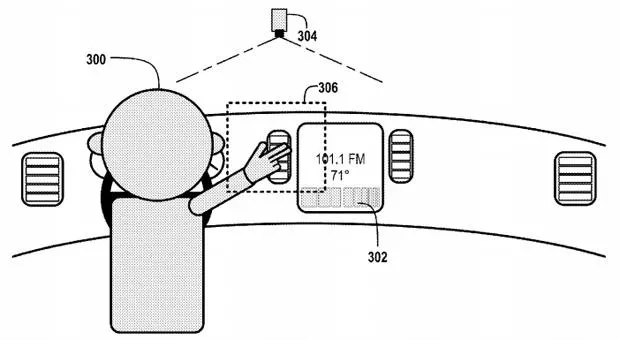

2013 年,科技媒体 Engadget 的一份报告称,谷歌提交了一项专利的申报,内容关于使用手部动作来更有效率地控制汽车。该专利依赖于安装在座舱顶部的深度摄像头和激光扫描仪,来根据驾乘者的手部位置和动作来触发车辆的相关功能。譬如在窗户附近滑动,会自动摇下车窗;用手指向车载收音机,系统会自动提高音量。

与此同时,车企们也没有闲着。2014 年的美国 CES 上,起亚发布了一款名为「KND-7」的概念车,该车就配备了手势识别信息交互系统。

江淮汽车在 2014 年的北京车展上展出了 SC-9 概念车,搭载了名为 PHONEBOOK 的人机交互系统,基于 Windows 系统开发。紧贴中控屏的下方有一块面积不小的感应区。不仅能通过各种手势识别操作车机,还支持隔空书写功能,发布时仅支持英文输入。

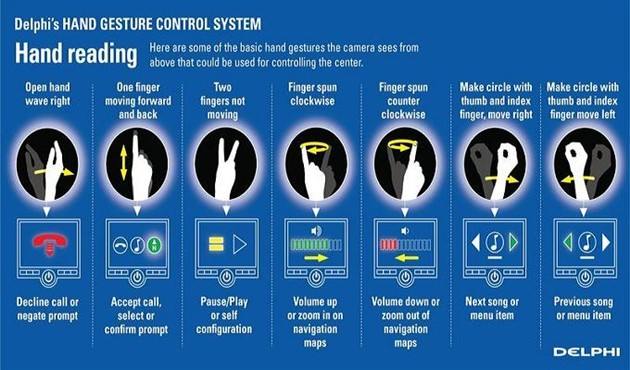

宝马的手势控制系统最开始在 2015 年推出的 G11/G12 7 系上首次亮相,这也是隔空手势第一次见于量产车型,供应商为美国德尔福。使用者只需在空气中比划一些预设的手势,中控台上方的 3D 传感区域就可以快速检测和识别手势动作,方便地控制音量或导航等功能。

比如,将食指指向前方并顺时针旋转就可以增大音量,逆时针旋转则对应降低音量;冲着车机屏幕比个水平的 V 形手势可以打开或者关闭;在车机屏幕前挥动手掌可以拒接或忽略提示,用手指「单击」空气则对应接听电话或确认提示。

放眼国内,同样的交互形式,自主品牌们给出了不一样的答案。

2018 年上市的君马 SEEK 5,提供了 9 种隔空手势交互,由中控屏下方的专属摄像头进行识别。

当有来电呼入时,冲着屏幕比出电话听筒的手势,正面代表接听,反之代表挂断。

看到这里,想起了某位交互设计师在文章中讲过一个故事:一位年轻的幼儿园教师让小朋友们一起表演打电话,小朋友们纷纷学着接听手机的样子把手掌贴到耳旁,只有他自己举起了比「六」的手势。这里,文化的隔代与差异决定了认知的不同。

四指聚拢伸出拇指向左或向右,代表切歌。

伸出手掌朝上运动示意「过来」代表音量增加,向下示意「坐下」的动作代表音量减小。

水平的 V 形手势操作音乐的播放与暂停,以及从攥拳到摊开手掌,屏幕上会出现一朵绽放的玫瑰花,仪式感该死甜美的。

长城的 WEY 摩卡搭载了手势召唤功能,车主可以在车外隔空徒手控车。

不得不说,任谁看到这一幕大概都会想起,自己在停车场管理人员的帮助下停车入位的场景,只不过原本的两个人类,在这里换成了一人一车。

2021 年面市的福特 EVOS 上,长达 1.1 米、既能一分为二又能合二为一的屏幕令人印象深刻。为了让使用者更好地用起来这块屏幕,福特 EVOS 的团队还设计了一系列交互手势:

将食指放在嘴唇上比个「嘘」的手势,音乐就会自动暂停;

比个「OK」的手势,音乐就会重新播放;

比个 V 形手势,可以在分屏与全屏之间切换;

比个五指抓取的动作,就可以直接回到的主页面。

南拳北腿 隔空手势背后的技术流派

前面说过,实现交互的大前提是感知与智能。已知的主流手势交互有两大技术流派:

雷达派:

该流派的技术主要通过微型毫米雷达波监测手部动作,达到手势识别的目的。

这里就不能不说谷歌在 2015 年公布的 Project Soli,一项通过运用微型雷达监测空中手势动作的传感技术。通过特殊设计的雷达传感器追踪毫米精确度的高速运动,然后将雷达信号进行处理之后,识别成一系列通用的交互手势。

经过持续不断的研发,Soli 雷达实现毫米级大小,所以能够十分方便地塞进手机与可穿戴设备之中。

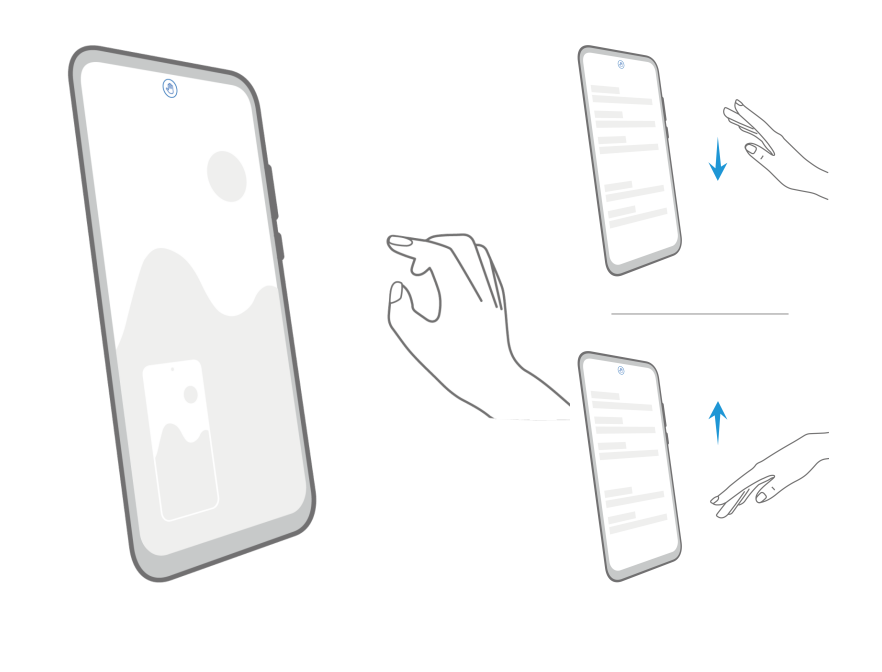

Project Soli 最著名的落地案例之一就是 2019 年谷歌发布的 Pixel 4 手机,其借助 Soli 雷达实现了名为 Motion Sense(运动感应)的技术。用户无需接触屏幕,就能通过隔空手势实现一系列操控动作,比如切换音乐、静音手机、调节闹钟声音大小等等。Pixel 4 的面部解锁也依靠毫米波,甚至对光线没有任何要求,黑暗中也能完成解锁。

视觉派:

该流派通过计算机视觉来识别手部特征点,应用相较前者更加广泛。

尽管 Soli 雷达为代表的技术流派有着方向性强,抗环境干扰能力强等优点,但这不妨碍车企与供应商们对通过计算机视觉实现手势操控的路径青睐有加。

也许很多人还记得微软 XBOX 系列游戏主机上的 Kinect 体感外设。微软 Kinect 采用的深度感应技术能够自动捕获人体的深度图像,并实时的跟踪人体骨架,检测到细微的动作变化。

手势识别技术由简入深大致可以分为三个等级:二维手型识别、二维手势识别、三维手势识别。如果我们只需要满足「播放/暂停」这类最基础的控制,二维层面的手型/手势+单个摄像头捕捉的组合就足以满足需求。像智能电视上播放着流媒体视频的客厅场景,当我们要短暂离开又不想错过内容时,只要做个简单的手势就能让电视暂停播放。

但车内的空间感不像沙发与客厅这么简单,所以包含更加有深度信息的三维手势识别是必要的,相应摄像头硬件的复杂程度也会增加。

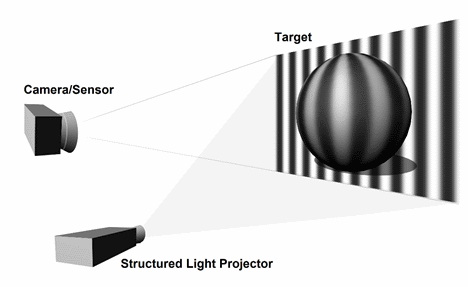

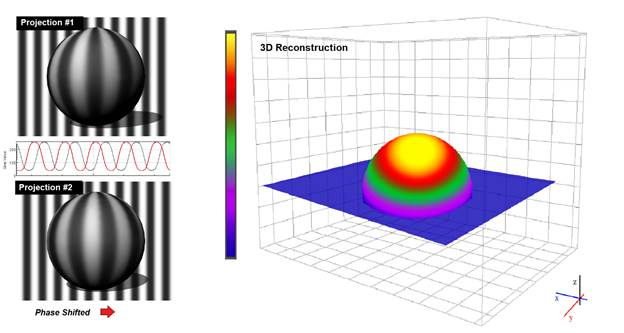

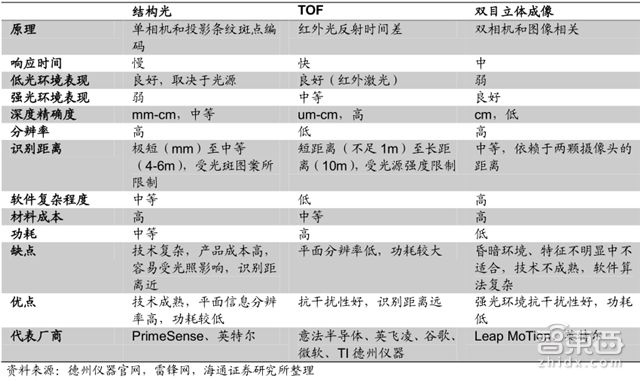

支持微软 Kinect 实现隔空交互的深度感应技术,前后两代可以分别拆解出手势交互的两种主流技术路径: 架构光(Structure Light) 和 光飞时间(Time of Flight),再加上 多角成像(Multi-Camera),就构成了手势交互的三个主要视觉技术流派。

结构光(Structure Light)

代表应用:XBOX 360 上的初代 Kinect by 供应商 PrimeSense

原理:激光投射器发出的激光通过特定光栅进行投射成像时会发生偏折,使得激光在物体表面上的落点产生位移。使用摄像头来检测采集投射到物体表面上的图样,通过图样的位移变化,用算法计算出物体的位置和深度信息,进而复原出整个三维空间,根据已知图案进行手势的识别和判断。

以 XBOX 360 上的第一代 Kinect 而言,只有在距离 1~4 米的特定范围内才能实现最佳识别效果。这是因为该技术依赖于激光折射后产生的落点位移,所以太近太远都不行,在应对物体反光干扰方面也不是很出色,但胜在技术相对成熟且功耗相对低。

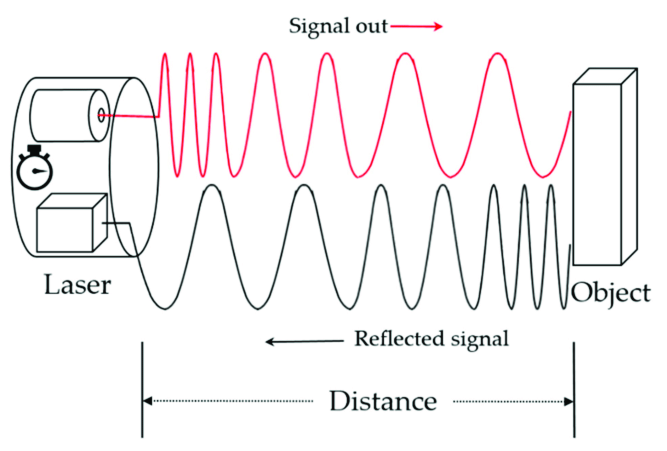

光 飞 时间(Time of Flight)

代表应用:Intel 感知计算技术 by 供应商 SoftKinetic(已被 Sony 收购)、XBOX ONE 上的 Kinect 二代

原理:原理如名称所示,也是三条技术路径中最简单的一条。由发光元件向被测目标连续发送光信号,然后在特别的 CMOS 传感器端接收从被测目标返回的光信号,通过计算发射/接收光信号的往返飞行时间,得出被测目标的距离。与结构光不同的是,设备发射出去的不是散斑,而是面光源,所以理论工作距离范围较前者更远一些。

TOF 对理解上再简化一些的话,TOF 类似于我们所熟知的蝙蝠的感知原理,只不过发射与的不是超声波,而是光信号。TOF 的抗干扰性和识别距离相对更高,同时也被视为最有发展前景的手势识别技术之一。

附带一提,借助近期理想 L9 的 剧透 传播活动,3D TOF 技术又小火了一把。

多角成像(Multi-Camera)

代表应用:凌感科技 Usens 的 Fingo 手势交互模组、Leap Motion 公司的同名体感控制器

原理:使用两个(或以上)摄像头对当前环境进行拍摄,得到两幅(或以上)针对同一环境的不同视角照片,根据几何原理来计算深度信息。因为复数摄像头的各项参数以及彼此之间的相对位置是已知的,只要找出相同物体在不同画面中的位置,就能通过算法计算出被测物体的识别效果。

理解上简化一些的话,双目摄像头就类似人类的双眼,多目摄像头就像昆虫的复眼,通过算法来形成多角三维成像。

多角成像在三者中属于比较极端的一个。一方面,多角成像对硬件的要求是最低的,另一方面因为完全依赖于计算机视觉算法,计算畸变数据对算法要求又非常高。相比于结构光与 TOF 技术,多角成像的实际功耗要低得多,强光环境下抗干扰性优秀,算是一种物美价廉的手势识别技术路径。

图片来源:智东西《华为小米 OV 手机 AI 大战的帮凶!》

所以,手势交互到底靠不靠谱?

让我们回到标题中的问题,手势交互到底靠不靠谱儿?

我的答案是肯定的。 不管是现在还是完全自动驾驶实现的将来,车内的手势交互都有着巨大的应用潜力,只是现在还为时尚早。

车企们和供应商们已经很难在物理按键上再玩出什么花活了,在触控屏的形状、尺寸、材质上大做文章一时半会儿又没能内卷出革命性的实用创新,只有风头正盛的智能语音还在技术发展的行业红利期。

留给手势的发展空间不小,技术限制只是一方面,事实是现实中存在大量需要 HMI 设计师、产品经理和供应商们考虑和解决的问题。

识别率与稳定性

人工智能领域一直以来面临的最大挑战之一,就是如何让不具备人类常识和通识的智能去理解现实世界。算法如何区分人类的真实交互意图,和那些意外、不经意、自然而然的手势?

表象是用户认为自己做对了手势,系统却不能正确识别;用户不经意间的手势动作,却被系统「精准」捕捉并执行。

2021 年我们进行智能座舱评测工作时,某次车内摄像头根据捕捉到的图像,反复意外触发了车内吸烟感知,并进行强制开窗换气。但当时我只是在思考问题时,习惯性做出手扶下巴的动作。这种小意外贯穿了整个工作过程,虽然还说不上不堪其扰,但观感仍然不好。

背后可能的原因有很多,如果环境干扰影响、算法识别阈值过高、超出识别范围、动作不标准等等。但一味提升识别率绝不是正确的解决方法,就好比座舱语音中的免唤醒是个很好的特性,但无脑的全局免唤醒会让系统分不清用户是指令交互、自言自语还是跟别人说话,会造成大量困扰。

如果手势不能有效区分这些动作背后的意图,不稳定的表现会更加令人困扰。技术限制当用户需要不情愿地付出时间和注意力成本去抚平这些意外的麻烦,或是在需要用到的时候无法得到期待中的正确回应,那对交互来说便是真正的本末倒置了。

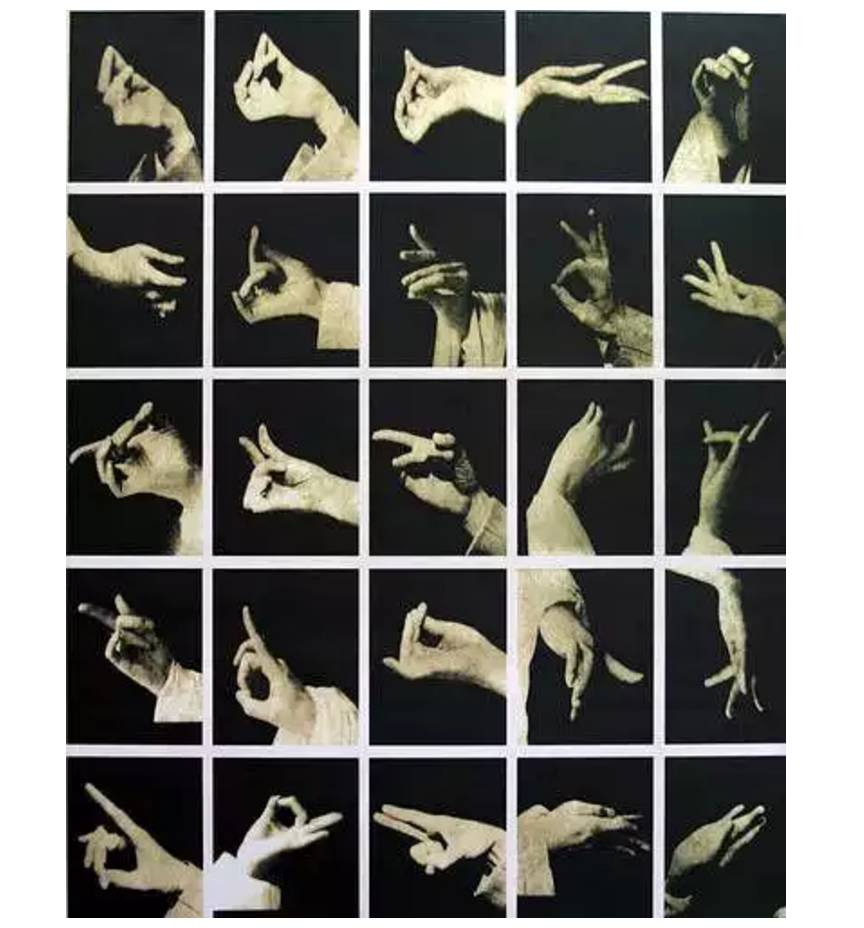

文化异同性

前面举过幼儿园小朋友打电话的例子,我们能看到,只不过是从 90 后到 10 后的时间跨度,对「打电话」这个动作的认知就是已经完全不一样。这代表了手势意义的表达受到了代际文化的影响。

已经成为全球通用手势的「OK」,这两年经社交网络衍生出的用法,又让韩国的年轻男性们破了大防,已经严重到了宣传中类似的符号一旦遭到公众质疑,品牌就要取消并道歉的程度。

让我们再举个简单的例子。

就拿女孩子们拍照时最喜欢摆的剪刀手造型来说,英语文化里称作和平手势(peace gesture),又有表示胜利(victory)的意思;手背冲着对方比出的 V 字手势在英国代表了一种十分具有进攻性的冒犯意味,一说是在英法百年战争时期的阿金库尔战役中,被英格兰长弓手们用来向那些战前放狠话要废了他们功夫的法军嘲笑和炫耀。后来,「胜利与和平」手势又通过时任英国首相温斯顿·丘吉尔在二战时期的那张著名照片,无意间被发扬光大。

看似简单的手势包含了无数的可能性,不同手势在不同国家,也被赋予了完全不同的意义。

所以 HMI 设计师与产品经理们在设计手势时,也需要更多考虑各地的文化背景和风俗习惯。

学习成本

你能记住几组交互手势?对我来说,常用的三、四组已经是极限了。

华为在近年来的旗舰手机上大胆应用了几组隔空手势,比如手心朝前五指抓取的动作代表截屏、上下甩手代表纵向滑动等等。

好用吗?确实在多数场景里,还挺好用的。实际情况是,日常使用 Mate 30 Pro 的那段时间里只有隔空截屏比较常用,还得是在光线相对充足的环境中才能实现。

我认为华为在这方面已经十分克制。众所周知,人类的手部姿态千变万化。京剧大师梅兰芳先生发明的梅派五十三式兰花指法,单是看图鉴就已经让人眼花缭乱。

当然,梅先生的兰花指法是以艺术表达为核心的,与强调工具性的手势交互有很大区别。

手势既然是以直觉为出发点的交互,设计也需要更加符合人类直觉,容易被记住,容易被使用,容易成为习惯。

所以我们需要的是——

每次有新技术产品问世的时候,人们总是喜欢讲「未来已来」。

让我们褪去浪漫主义的外衣,技术的研发、产品的规划、预期的传达、反馈与迭代实际上是个无比漫长的过程。一步到位只能是美好的愿景,不然研发行为本身也没了意义。

手势交互对于触摸、语音来说是很好的补充,甚至基于一些场景或个人意愿下会优于前两者。当然,不同的感知方法与交互之间彼此结合、相互配合,要比单独指望一种极为发达的感官,要更符合产品迭代的逻辑,物种进化亦是如此。

就像前面提到的误唤醒现象,如果车内摄像头能够和 AQS 空气质量传感器读数相配合来判断的话,就会知道我只是在沉思时习惯性地扶着下巴,而不是在吸烟,更不是在耍酷。

我相信这个未来不会太久。

行家说

任何一种解决方案都是能够有效地解决某个有价值的艰巨问题时才有价值。手势交互的问题在于,它没有突破性地解决座舱交互的显著问题。 座舱交互的核心瓶颈,在于激增的任务复杂度和低视觉认知资源投入的矛盾。 既要用户轻松、安全地开车,又要完成设定目的地、浏览选择歌曲这样的复杂任务。

而手势交互,尤其是隔空手势交互,相比触摸、语音和实体交互,并没有办法解决上述瓶颈,只会带来更大的麻烦。这包括,手势需要用户重新学习,手势的 sensor 本身准确度不足导致误操作,手部悬空所导致的手部疲劳。

在触摸屏上少量的手势交互是可以考虑的,比如返回上一级、返回首页。这些少而精的手势必须简单易学、符合直觉,且只能作为备用的高级操作提供给熟练用户。普通用户仍然需要「可见」的控件,从而避免学习门槛。