美国洛杉矶车辆管理中心(California Department of Motor Vehicles )发布了去年的交通事故报告,报告中有几起自动驾驶汽车发生的交通事故,非常具有代表性。

之前有不愿意透露姓名的知情人士表示:谷歌自动驾驶汽车发生事故的概率比人类驾驶员要小得多,但是他当时并没有具体描述自动驾驶汽车事故的细节。

现在 CDMV 的报告详细描述了每一起事故的细节,通过分析这些事故,我们发现确实在大部分事故中,人类驾驶员的失误才是导致事故发生的关键因素。

这次总共发布了 9 份事故报告,其中 2015 年中的 8 次事故涉及到了谷歌的自动驾驶汽车。相对于 20 辆自动驾驶汽车平均每辆每周行驶 16000 公里的里程来算,发生了 8 起事故并不算多。

事故报告显示,在谷歌汽车涉及到的这几起事故中,大部分都是由于在路口没有及时停下来或者是通过路口时车速太快导致的,除了被其他车辆追尾的那次。

安全的度该如何把控?

在所有的事故中,有一起事故非常特别,这是由于谷歌的自动驾驶测试车过于谨慎导致的。在今年 2 月 25 日,一辆基于雷克萨斯 RX450h 改造的测试车,在向北行驶通过一个十字路口时,检测到了一辆由东向西通过路口的奥迪车有可能和自己发生碰撞,于是这辆车自动刹停了下来,奥迪车躲闪不急,撞到了雷克萨斯的右后门和后轮的位置。

虽然最后判定奥迪车主对这起事故负责,但如果事故的其中一方不是自动驾驶车辆的话,这起事故可能就不会发生了。

因为在事故发生之前,测试车根据奥迪的速度和轨迹计算出有可能发生碰撞,提前开始制动。而奥迪车的驾驶员,并没有意识到这是一辆自动驾驶汽车,或者说,以他以往的经验判断,前面的的那辆车应该会加速通过路口而不是减速。于是,事故发生了。虽然在事故发生的前一刻,测试车里的驾驶员已经切换到手动模式,并且尝试做出规避动作,但并没有来得及。

这起事故暴露出了自动驾驶汽车的一个问题:有些事故并不是人类驾驶员的失误导致的,而是因为自动驾驶汽车的行驶轨迹,有时并不符合人们的日常的行驶习惯。因为自动驾驶汽车过于注重安全了。

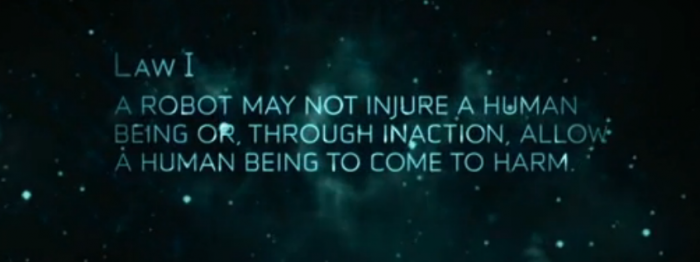

不过我认为这并不是自动驾驶汽车的错。毕竟人们在最初刚刚萌生了智能机器人幻想的时候,就为它们定下了机器人三定律:1. 机器人不得伤害人类个体,或者目睹人类个体将遭受危险而袖手旁观。2. 机器人必须服从人给予它的命令,但不得违反第一定律。3. 机器人应保护自身的安全,但不得违反第一、第二定律。

这条 1942 年就提出的定律,从始至终只在强调一件事情,安全。对于自动驾驶汽车来说,最难的并不是知道要沿着哪条道路行驶,而是如何像人类一样在道路上行驶。做到真正的「智能」是非常困难的,直到去年已经有程序「通过」了图灵测试,但「他」的身份是一位 13 岁的小男孩,显然还不够合法开车上路的年纪。

原创声明: 本文为 GeekCar 原创作品,欢迎转载。转载时请在文章开头注明作者和「来源自 GeekCar」,并附上原文链接,不得修改原文内容,谢谢合作!

同时欢迎关注 GeekCar 微信公众号: GeekCar 极客汽车 (微信号:GeekCar)& 极市 (微信号:geeket)。

自动驾驶的目的就是要取代人去驾驶的,如果不是以此为目的去做,那不叫自动驾驶,那是辅助驾驶。说什么网络互联,交通事故认证谁的责任问题,那都是屁!车要自动驾驶,最起码不能脱离人的思维过程。交通法则及驾驶规程都是以数据库形式记录在汽车电脑中的,如果完全以交通规则及驾驶安全规则去驾驶的话,计算机要比人可靠得多。事故率会减少很多。另外,谷歌测试当中一些事故本来就可以避免的,只因为程序设计的问题发生一些事故,这只能说这辆车的程序设计有瑕疵。譬如这起事故中,谷歌无人车准备采用出道转弯的方式来转弯,但是前方遇到了一堆沙袋。当交通灯变成绿灯后,它先等几辆车驶过,然后看到一辆公交车。对于公交车司机来说,道路上有足够的空间让他开过去。但是对谷歌无人驾驶汽车来说,系统预测公交车会减速让无人车并线进来,但是这辆公交车并没有,结果两辆车就撞到了一起。这说明它的程序设计不是以人思维过程而是以机器为主导过程。人在那样的情况下,首先确定路况,不仅仅去分析当前路况能不能通过,还要看一下周围的车辆,多少,位置,驾驶状态去确定自己需要以什么状况,车速下通过。而这些谷歌并没有想到,或者并不完善。所以车辆的一慢二让三通过的特性没有看到。做自动驾驶车,首先让其有人驾驶的思维过程。再让车去配合这个驾驶过程,至于什么网络互联,交通事故不好责任认证,那都是屁!人驾驶在上述状况中出现事故,能不能认定责任方?